Cripsis en un render

Esto no es VFX

La serie de Jonas Ussing en The Movie Rabbit Hole. Esa debería ser la newsletter ya que se trata de un recorrido maravilloso por el estado de la cuestión del CGI. Básicamente desentraña esa promesa de la película sin CGI: lejos de ser un mantra de autenticidad, se trata de la fusión perfecta entre matte paintings y texturas digitales. O lo que es lo mismo, todas las películas usan CGI, lo quiera o no Tom Cruise o Christopher Nolan. Ussing nos muestra cómo en Nuke, cada capa de pintura a mano se empalma con grabados antiguos escaneados, se aísla la silueta con nodos de Keyer y se simula el motion blur analógico para que el ojo no perciba el salto entre lo real y lo retoque digital. En Oppenheimer, esas explosiones nucleares se construyen con miniaturas reales, sí, pero luego entran en juego simulaciones de fluidos en Houdini: un solver FLIP genera humo y ceniza que luego se exporta como volúmenes, se ajustan los atributos de shader en Maya y se renderizan con pases separados.

La tecnología de limpieza de set es otro capítulo fascinante. Cada micrófono y cable visible se elimina mediante roto‑painting en Nuke, pero la verdadera artesanía llega al combinar trackers que siguen movimientos complejos para reconstruir fotogramas con datos de proximidad. El resultado es una escena donde la cámara virtual no encuentra rastro de los auxiliares de rodaje. A esto se suma la gradación de color donde se aplican LUTs 3D personalizados para evocar el grano del 16 mm y se ajustan curvas RGB que equilibran realismo y atmósfera de época.

Cuando Ussing se centra en cómo el CGI perjudica la capacidad interpretativa, desmonta el mito de la espontaneidad digital. Las pantallas verdes agresivas, con un Keylight que rasga el canal alfa dejan a los actores reaccionando a simples bloques de color. Sin un LED que proyecte el fondo real sobre el set, los brillos de la luz en piel, los metales o incluso los ojos quedan ausentes, y la actuación pierde contrastes esenciales. A través de proyectos de Maya AVC, muestra cómo los mocap placeholders (esas pelotas de ping‑pong que sirven de referencia) provocan desfases de timing al reasignar puntos de control en rigs digitales (o esqueletos usados para animar figuras), rompiendo la conexión emocional que se busca transmitir.

La supuesta sencillez retro de Barbie también es analizada en sus vídeos. Ussing muestra el workflow de escaneo LIDAR de un patio real para generar un HDRI en forma de mapa ambiental de 32 bits, esencial para que los reflejos en plástico y metal coincidan con la iluminación natural. Eliminan la pantalla azul y añaden efectos de blur para que la transición sea imperceptible. Para rematar el homenaje retro, aplican grano en postproducción de 35 mm y animan curvas de color que reproducen la paleta pastel y las imperfecciones de celuloide.

La IA en VFX

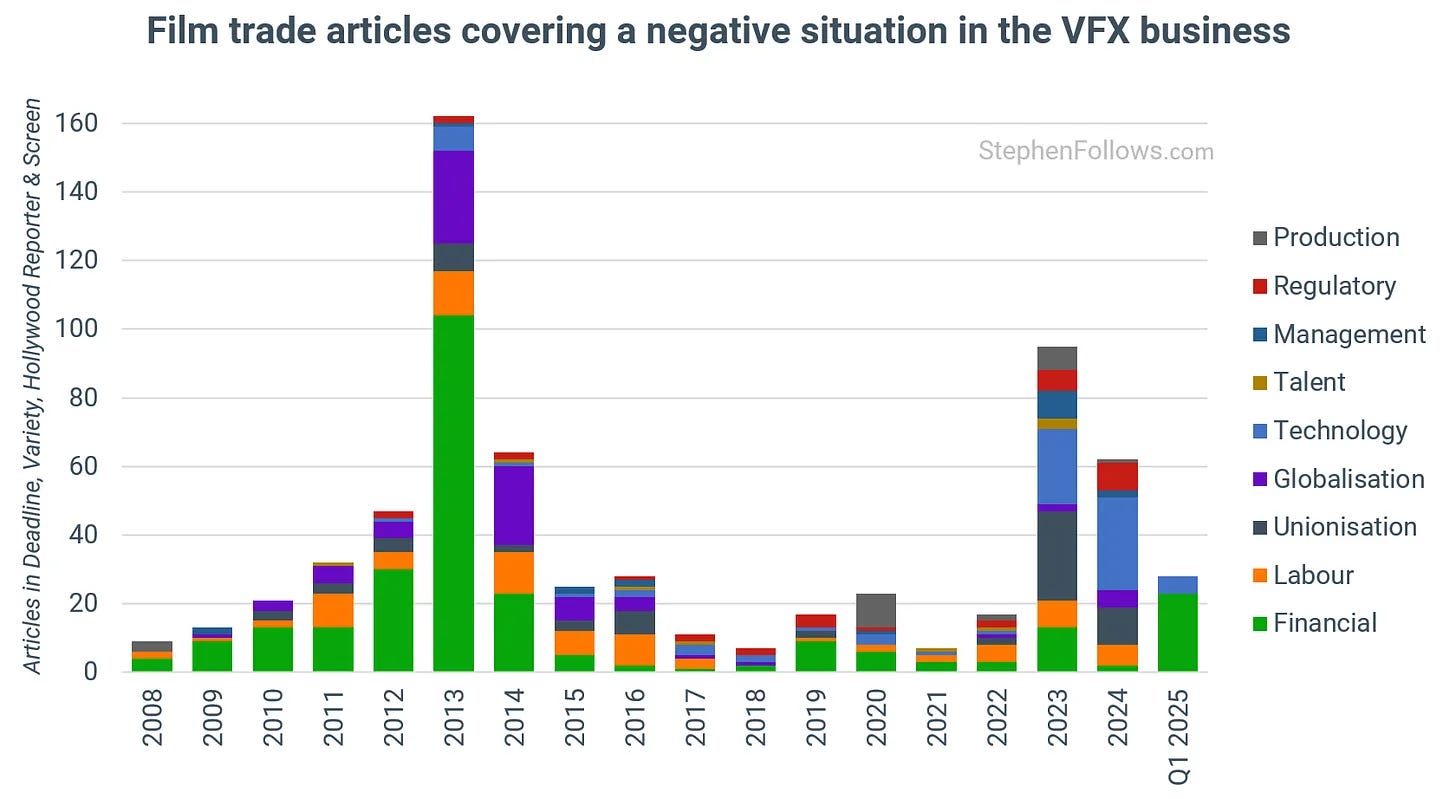

El panorama actual de la industria de los VFX es, para ser francos, delicado. Con empresas cerrando y mucha gente en la calle, la aparición de una tecnología tan revolucionaria como la Inteligencia Artificial genera una polarización: para algunos, es una nueva oportunidad, para otros, una amenaza inminente que viene a quitarnos el trabajo. Este contexto de incertidumbre se agudiza con la irrupción de BO3, la nueva IA de Google, cuya evolución ha sido exponencial en tan poco tiempo.

¿Para qué generar un modelo 3D que luego hay que llevar a programas como Blender o Houdini si se puede generar un vídeo directamente, ahorrándose toda la parte 3D? En esas están muchos mentecatos, cuando la realidad es que la devaluación del trabajo artesanal en digital terminará con una pobreza estética más que evidente.

El corazón del debate reside en el control. En VFX, y en el cine en general, el control creativo es primordial. Los directores como David Fincher toman incontables decisiones, desde la posición de la cámara hasta el más mínimo gesto de un actor, para contar una historia. Un director o un artista siempre busca el control absoluto sobre su obra, o eso se afirma en el debate entre esos dos artistas de VFX.

Aquí es donde las herramientas de IA generativa actuales, aquellas donde simplemente escribes un prompt y obtienes un resultado, muestran su gran limitación. Para el trabajo profesional en VFX, estas herramientas "no sirven para absolutamente nada". Aunque el output sea visualmente resultón (como las tomas estáticas o los primeros planos de BO3 que son indistinguibles de la realidad), carecen de la capacidad de permitir al artista o director el control preciso sobre el timing, la pose, la composición, la iluminación, y la narrativa.

La excepción, y la única herramienta que hoy por hoy se considera útil para ciertos usos en VFX, es Comfi UI. A diferencia de los generadores de prompt, Confi UI es una interfaz que permite un flujo de trabajo procedural, similar a programas como Houdini o Nuke, donde se construyen complejos árboles de nodos y conexiones para obtener un control preciso del creador. Esto es lo que la hace útil, pero también la vuelve bastante complicada de usar, desmintiendo la idea de que la IA hará todo fácil. Al ser de código abierto, el carácter comunal de la aplicación podría dibujar un horizonte donde la IA agilice los pipelines o aplicaciones intermedias de los estudios y profesionales de la VFX para solventar los trabajos más tediosos/automatizados y centrarse en el aspecto más creativo, pero, ¿eliminar el componente rutinario del trabajo garantiza una mayor creatividad? Otro debate más.

El debate también se extiende a terrenos éticos y legales. La pregunta de si "alguien ha pedido" estas herramientas generativas es recurrente, insinuando que son las grandes empresas tecnológicas las que intentan imponerlas. Ya hay precedentes legales importantes, como las demandas de Disney y Universal contra Mid Journey por el uso de material protegido por derechos de autor. La discusión sobre si se puede controlar el input (el material usado para entrenar la IA) o solo el output (el resultado generado) es compleja y vital para la regulación futura.

En cuanto al impacto en el empleo, se reconoce que la IA podría encargarse de tareas repetitivas y no creativas dentro de los estudios de VFX (como paint o roto), liberando a los artistas para roles más complejos como la composición. Sin embargo, la preocupación por la eliminación de roles junior es grande, ya que esto podría afectar la formación de futuras generaciones de artistas y disminuir la calidad del trabajo de la industria a largo plazo.

A pesar de toda la incertidumbre y la vertiginosa evolución de la IA, hay algo que se mantiene inalterable: los fundamentos artísticos. La teoría del color, la iluminación, la composición, las físicas y la dinámica del movimiento son habilidades atemporales que ningún prompt o algoritmo puede reemplazar por completo. Si un artista domina estos fundamentos, la herramienta que utilice es secundaria.

Para sorpresa de nadie, aún no he visto Superman. Ni voy a incurrir en polémicas ni a soltar algo de cebo, simplemente no me ha picado la curiosidad aún ya que ando algo saturado del cine de superhéroes. Sí he visto el tráiler y mi aburrimiento hizo que revisara en IMDB las cámaras y lentes que ha empleado James Gunn. Dado que no sé mucho de técnica o cámaras o lentes, es un ejercicio que suelo hacer para empaparme un poco del aspecto más técnico del proceso de la película. Lo que he descubierto es que uno de los elementos más interesantes descubiertos es el uso de una lente Leica Tri Elmar. Esta lente es en realidad tres lentes en una: una de 16mm, una de 18mm y una de 21mm. Todas ellas son lentes gran angular y su uso es evidente en muchas tomas, lo que contribuye al aspecto de gran angular general de la película. La capacidad de seleccionar y cambiar entre estas tres distancias focales dentro de una misma lente es una característica particular.

En cuanto a la cámara, se está rodando con una Red V-Raptor, que es una cámara de cine de gran formato. El uso de cámaras de gran formato es una tendencia actual. Cuando esta cámara de gran formato se combina con lentes gran angular, como la Leica Tri Elmar, el resultado son estéticas un tanto estridentes (no lo digo con valoración alguna). Esta combinación también contribuye a lo que se conoce como el aspecto de fotograma completo (full-frame look), que es muy popular actualmente. Con este aspecto, una lente de 50mm, por ejemplo, se ve realmente como 50mm sin distorsión, y la imagen resultante se siente más ancha de lo que se obtendría con cámaras de 35mm o Super 35. Este enfoque genera un aspecto irreal hiperrealista, a falta de que alguien le ponga un nombre mejor.

¿Con qué no perder el tiempo? Con cualquier juego de fútbol. A servidor se le ocurrió probar el último FIFA (o EA Sports, o FC nosequéformadeestafaraniñosconsobrecitos) para ver en qué habían cambiado en los últimos casi quince años (última que toqué un PES). Han cambiado en todo, para mal. Conclusión: me instalé el Football Life 2025, un ¿mod? construido por la comunidad sobre el PES 2021 y actualizado a día de hoy que al menos recuerda vagamente a los tiempos de los PES originales (y esto solo lo sabrán los que superen cierta edad). Y eso es todo, pasad buena semana y considerad compartir la newsletter si os gusta algo de lo que digo, ¡muchas gracias! ^_^